Unidad 1. Introducción al cálculo en dos variables.

1.1 Funciones en dos variables.

1.2 Derivadas parciales.

1.3 Máximos y mínimos de funciones de dos variables.

2.1 Antiderivada.

2.2 Integral indefinida.

2.2.1 Integración con condiciones iniciales.

2.3 Fórmulas básicas de integración.

2.3.1 Integral indefinida de una constante.

2.3.2 Integral de una constante por variables.

2.3.3 Integral de x.

2.3.4 Integral de e.

2.3.5 Integral de una constante por una función de x.

2.3.6 Integral de una suma (diferencia) de funciones.

2.3.7 Regla de la potencia.

2.3.7.1 Integrales que incluyen u.

2.3.7.2 Integrales que incluyen funciones exponenciales.

2.3.8 Integrales que incluyen funciones logarítmicas.

2.3.9 Integrales que incluyen (1/u) du.

2.3.10 Integrales que incluyen a.

2.3.11 Integrales por partes.

2.4 Aplicaciones: Determinación de funciones de costo utilidades,

consumo y ahorro a partir de sus marginales.

Unidad 3. Integral definida

3.1 Área bajo la curva

3.2 Teorema fundamental del cálculo.

3.3 Propiedades de la integral definida.

3.4 Área entre una y dos curvas.

3.5 Aplicaciones: Excedente del consumidor y del productor,

valor presente y valor futuro.

Unidad 4. Sistemas de ecuaciones lineales y matrices.

4.1 Sistemas de ecuaciones lineales.

4.1.1 Definición.

4.1.2 Sistemas de ecuaciones lineales.

4.1.3 Métodos para resolución de sistemas de ecuaciones

lineales.

4.1.4 Sistemas de ecuaciones equivalentes.

4.1.5 Eliminación de Gauss y Gauss-Jordan.

4.1.5.1 Definición de matriz.

4.1.5.2 Expresión matricial de un sistema de ecuaciones

lineales.

4.1.5.3 Operaciones elementales sobre renglones.

4.1.5.4 Reducción de Gauss y Gauss-Jordan.

4.1.5.5 Sistemas homogéneos.

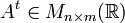

4.2 Algebra de matrices.

4.2.1 Tipos de matrices.

4.2.2 Operaciones con matrices.

4.2.3 Propiedades de las operaciones con matrices.

4.2.4 Matriz inversa.

4.3 Determinantes.

4.3.1 Definición de un determinante.

4.3.2 Expansión por cofactores.

4.3.3 Propiedades de los determinantes.

4.3.4 Regla de Cramer.

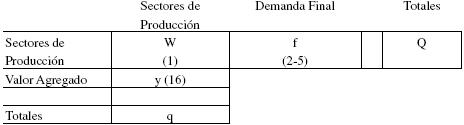

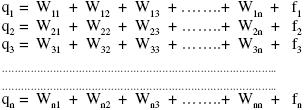

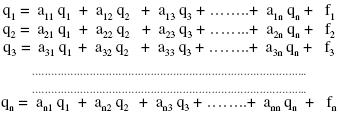

4.4 Aplicaciones: Modelo insumo-producto, análisis de ventas

y comportamiento del consumidor.

Bibliografía básica:

Matemáticas para

administración y economía Haeusler Pearson/ Prentice Hall, 10° Edición, 2008.

, las siguientes tres operaciones se llaman operaciones elementales de renglón en la matriz A:

, las siguientes tres operaciones se llaman operaciones elementales de renglón en la matriz A: , significa sustituir el iésimo renglón por el iésimo renglón multiplicando por C.

, significa sustituir el iésimo renglón por el iésimo renglón multiplicando por C. , significa que se sustituye el j-ésimo renglón por la suma del j-ésimo renglón más el iésimo renglón multiplicado por C.

, significa que se sustituye el j-ésimo renglón por la suma del j-ésimo renglón más el iésimo renglón multiplicado por C. , significa que se intercambian los renglones i y j.

, significa que se intercambian los renglones i y j.

da origen a la matriz

da origen a la matriz  .

. dá origen, si se parte de la matriz A, a la matriz

dá origen, si se parte de la matriz A, a la matriz .

.

.

. y

y  , como características, todos los elementos tienen la particularidad que sus subíndices suman (n+1), por ejemplo

, como características, todos los elementos tienen la particularidad que sus subíndices suman (n+1), por ejemplo  , donde 8 + (n - 7 ) = n + 1.

, donde 8 + (n - 7 ) = n + 1.

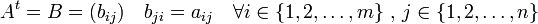

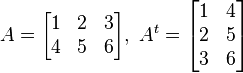

, se define la matriz transpuesta de

, se define la matriz transpuesta de  , denotada por

, denotada por  , como

, como  . Es decir, las filas de la matriz

. Es decir, las filas de la matriz  corresponden a las columnas de

corresponden a las columnas de  y viceversa.

y viceversa.

(2)

(2)

con

con  con

con  entonces

entonces  cuyo determinante se calculó en el ejemplo 2,

cuyo determinante se calculó en el ejemplo 2,

cuyo determinante se calculó en el ejemplo 2,

cuyo determinante se calculó en el ejemplo 2,